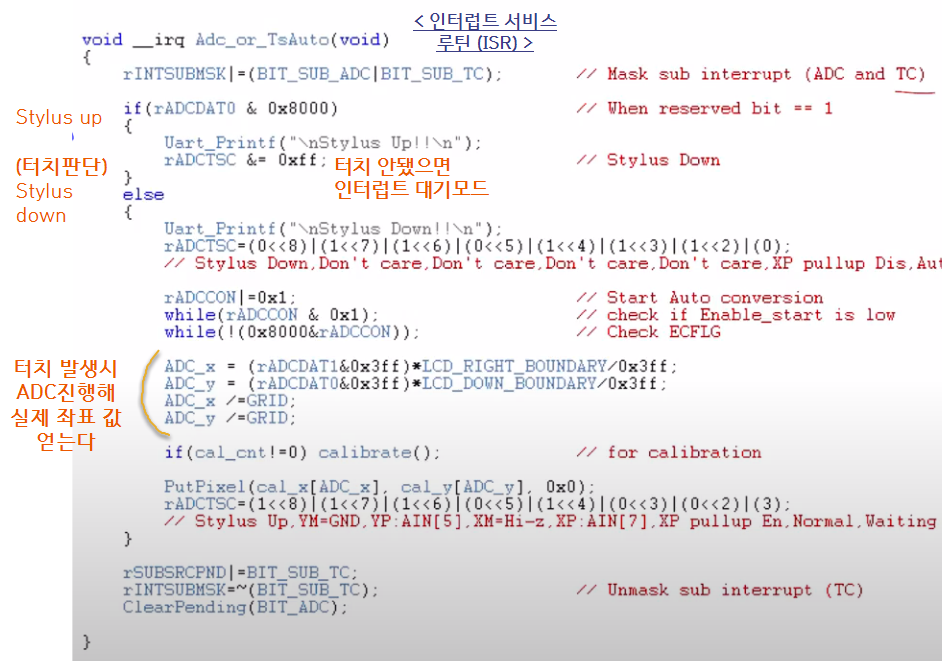

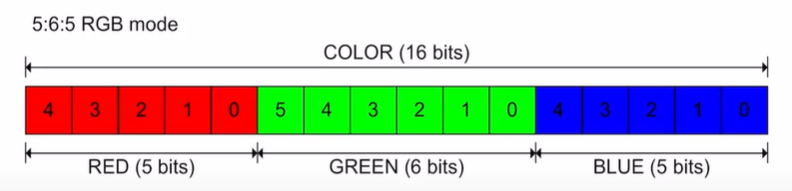

** (터치시 style down, 터치 안할시 style up) ** # 터치지점 아는 방법 lcd 아래에는 금속(전선)이 깔려있다. 이 전선들은 저항선분을 가지고 있다. 저항띠(선)에 터치를 할 시 거리에 따른 저항값이 다르다. 터치한 부분의 전압좌표를 알 수 있는데 이를 계산하면 터치좌표를 알 수 있다. - 이때, 전압은 소수점을 가지고 있는 실수값이다. 따라서 ADC(analog digital converner)을 이용해 cpu로 갈때 디지털 값으로 변환해 넘겨준다. # ADC set up (장치준비) - 데이터를 변환하는 시간과 데이터의 형태를 정한다. - 멀티터치가 아닌 모노터치 = 원터치 (좌표값이 하나만 인식이 됨) - 실습키트의 터치스크린은 저항성분으로 이루어져있는 스크린이다. (저항방식..